Initiative for Science in Europe (ISE) ha recentemente pubblicato un rapporto: Centrality of researchers in reforming research assessmen presentato in occasione della Paris Open Science European Conference (OSEC2022) qualche settimana fa.

Il report identifica 18 azioni che ricercatori, finanziatori, governi, università, enti di ricerca e editori possono intraprendere per riformare l’attuale sistema di valutazione della ricerca nell’ottica di una concreta transizione verso la scienza aperta.

In particolare, il rapporto individua quattro principi essenziali per il successo di una riforma della valutazione della ricerca:

- coinvolgere i ricercatori in tutte le decisioni che riguardano le modifiche del sistema di valutazione della ricerca

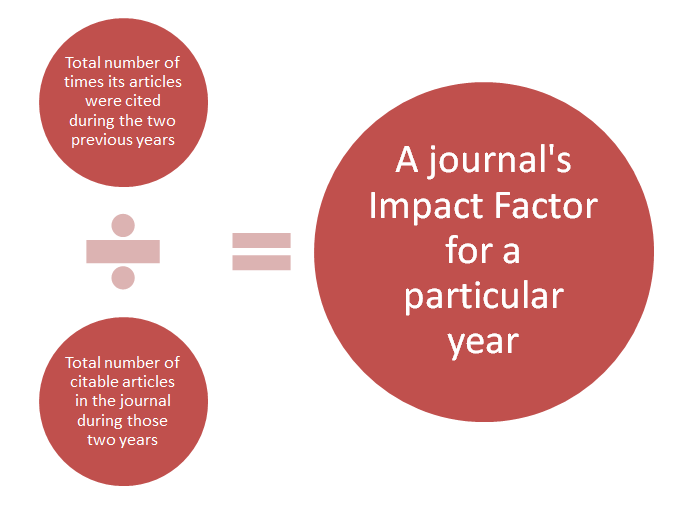

- tutte le parti interessate devono attenersi ai principi San Francisco Declaration on Research Assessment (DORA) sulla valutazione della ricerca e del The Leiden Manifesto e abbandonare l’uso di metriche inadeguate

- concordare modalità appropriate di valutazione della ricerca e dei ricercatori identificando adeguati mezzi di valutazione specifici per ogni disciplina; stabilire un adeguato equilibrio tra valutazione qualitativa e quantitativa; valutare quali metriche o indicatori possono essere eventualmente rilevanti ai fini valutativi

- riconoscere che la riforma del sistema di valutazione richiede risorse e pertanto finanziatori della ricerca, governi e le università dovrebbero fornire ulteriori finanziamenti dedicati alla scienza aperta

Il coinvolgimento diretto dei ricercatori è uno dei punti salienti di questo documento che sottolinea come tutte le parti coinvolte nel processo di valutazione debbano partecipare nel ripensare l’attuale sistema di valutazione avendo chiari quali obiettivi la valutazione si pone.

Segnaliamo un interessante

Segnaliamo un interessante  Public Library of Science (

Public Library of Science ( All’inizio di questo autunno, Clarivate Analytics ha

All’inizio di questo autunno, Clarivate Analytics ha

Segnaliamo la recente pubblicazione del volume

Segnaliamo la recente pubblicazione del volume